O Screaming Frog é uma ferramenta muito útil e acessível para auditar seus sites. Ela faz todo o processo de rastreamento e coleta de dados relevantes para SEO das páginas.

Esse processo, conhecido como Crawling ou rastreamento, é o mesmo processo que o Google faz para encontrar suas páginas e entender a estrutura de seu site e conteúdos!

O legal da ferramenta é que ela simula o próprio Googlebot para fazer o rastreamento, ou seja, ela “lê” as páginas como o Google as leria, o que te permite entender exatamente onde estão os problemas mais técnicos que podem estar impactando em sua performance no Google.

Ao utilizar o Scremaing Frog, você terá acesso a informações como as tags HTML(headings, meta robots, title, meta description…) de cada página, resposta HTTP (404, redirect 301,302…), quantidade de links internos e externos que cada página do site tem e muito mais!

Se você já utiliza a ferramenta ou que conhecê-la melhor, está no artigo certo!

Neste guia do Screaming Frog, quero passar por todas configurações importantes, integrações e funcionalidades mais relevantes da ferramenta.

Vou passar também por algumas funcionalidades “escondidas” e muito úteis, que com certeza vão te ajudar e fazer auditorias mais assertivas com o Screaming Frog, confira!

Como configurar o Screaming Frog antes de utilizar a ferramenta?

Antes de colocar a URL de partida e selecionar “Start” para iniciar o rastreamento de seu site, saiba que você pode e deve fazer algumas configurações prévias, para coletar as informações com mais assertividade, considerando as particularidades de seu site.

Vou passar pelas configurações mais importantes e algumas que você provavelmente não conhecia.

Sem mais delongas vamos lá!

Configurando o Spider para rastreamento e renderização

Spider é o nome dado ao robô utilizado para rastrear suas páginas. É ele quem vai seguir os links e coletar as informações de cada página.

Você pode configurar esse robô, para que ele suga algumas regras e padrões específicos. Para fazer isso, siga o passo a passo:

1.Acesse “Configuration” e clique em “Spider”

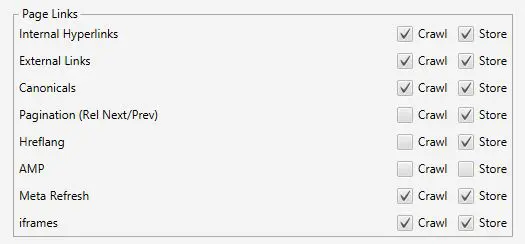

2. Dentro de spider, na aba “Crawl” você verá algumas seções como “Resource Links”.

Aqui você pode configurar como o Spider vai rastrear e armazenar as informações de cada recurso e link encontrado.

Se seu site usa AMP por exemplo, sugiro “dar um check” em crawl e store para AMP, o que permite que ele rastreie esses tipos de link e armazene suas informações.

Paginação e Hreflang também são dois links importantes de rastrear caso seu site tenha muitas páginas que queira analisar e versões de outros países.

Se você quiser apenas analisar as páginas de seu país, sugiro manter a opção Hreflang desmarcada.

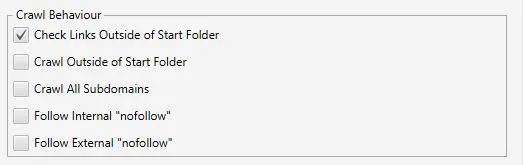

3. Ainda na aba “Crawl”, vamos falar sobre o “Crawl Behaviour”

Nesta seção, você define um controle para rastreamento do site. Você pode, por exemplo, dizer para o Spider que ele rastreie páginas fora da pasta inicial.

Ou seja, pense que você começou o rastreamento pela página: www.exemplo.com/dados.

Se você marcar essa opção, não só as páginas pertencentes à pasta /dados serão rastreadas, mas também aquelas que estão dentro de outras pastas como: www.exemplo.com/marketing.

Você pode também configurá-lo para rastrear subdomínios (como um blog.exemplo) e também para rastrear páginas mesmo que elas sejam marcadas com “nofollow”.

4. Por fim, dentro de “Crawl” chegamos à seção de sitemaps

Aqui você pode adicionar um sitemap específico que deseja que o spider rastreie, ou simplesmente permitir que ele encontre os sitemaps linkados pelo arquivo robots.txt!

Se você quer maximizar o potencial da ferramenta, recomendo linkar o sitemap nessa parte, para que ele encontre todas URLs, pois em alguns casos o sitemap não é linkado no arquivo robots.txt.

Para fazer isso, basta marcar as opções “Crawl Linked XML Sitemaps” e “Crawl These Sitemaps”, para então colar a URL do sitemap no espaço em branco!

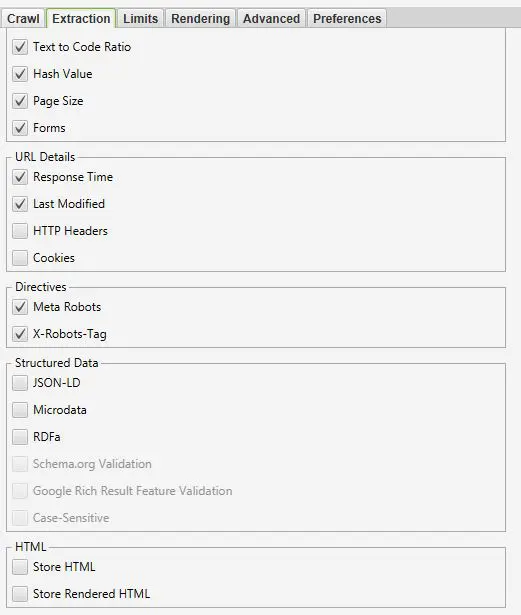

5. Chegando à aba “Extraction”

Essa aba se refere à extração das informações na página, ou seja, é aqui onde você indica para a ferramenta quais informações da página que deseja coletar para análise.

Sugiro deixar como está a configuração – com quase tudo marcado – apenas adicionando “Structured Data”, marcando JSON-LD, Microdata e a validação do Google/Schema, para validar se as páginas usam dados estruturados e se a implementação dos mesmo está correta.

Você pode também optar para que a ferramenta armazene o HTML das páginas, para usá-lo em análises mais aprofundadas, dependendo de sua necessidade.

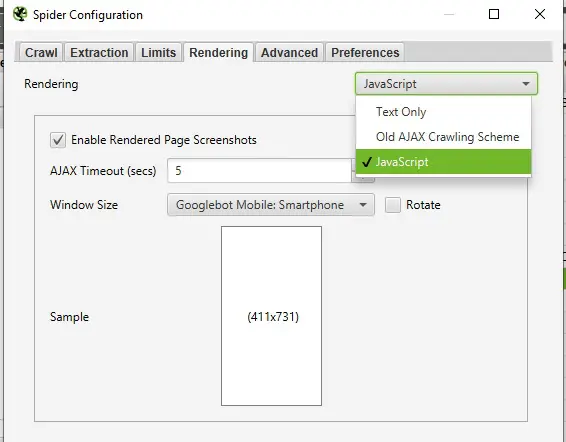

6. Na aba “Rendering” você pode escolher como o Screaming Frog deve renderizar suas páginas

Se você tem um site em JavaScript, por exemplo, pode optar pela opção “JavaScript” para que o Spider renderize todo o conteúdo gerado por JavaScript e possa trazer dados mais assertivos, até screenshots das páginas renderizadas, se você achar necessário (lemrbabdo que o uso desse recurso pode tornar o rastreamento mais lento e pesado).

7. Na aba “Advanced” você pode adicionar direcionamentos mais específicos ao bot da ferramenta

Aqui você pode, por exemplo, configurar o bot para que ele respeite as páginas marcadas com “noindex” e não apresente informações sobre elas, ou então para respeitar “Next/Prev” em paginação, trazendo informações apenas sobre a página inicial!

Enfim, são várias configurações que você pode fazer com base em suas necessidades. Costumo não mexer muito nessa parte, exceto em casos particulares.

Ao final dessa aba, você pode configurar o número de vezes que o spider deve tentar acessar uma URL quando ela retorna um erro 5xx (que é em geral um erro de servidor).

Como esses erros são temporários, eles podem enviesar bem os dados caso apareçam com frequência no relatório.

Portanto, ao possibilitar que o Spider tente ao menos umas 3 vezes, você diminui as chances de ter esse tipo de problema, que impossibilita a extração de dados da página que retornou o erro.

Importante: evite colocar muitas tentativas em um curto período de tempo. Isso pode sobrecarregar o servidor e causar justamente o erro que estamos tentando contornar (5xx).

Pronto!

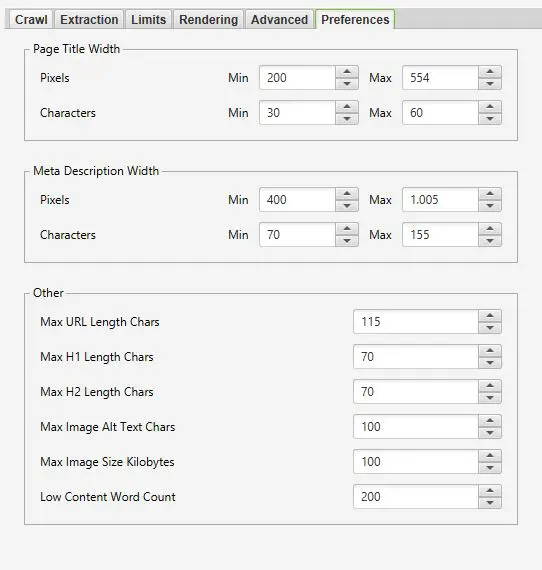

Na aba “Preferences” você pode configurar suas preferências em relação a diversos fatores, como o que deve ser considerado como um conteúdo pequeno (o padrão da ferramenta é até 200 palavras) ou title grande, por exemplo.

Em “Limits”, você pode determinar alguns limites de URLs a serem rastreadas como quantidade máxima de links em uma página para rastrear e a quantidade máxima de redirects para seguir.

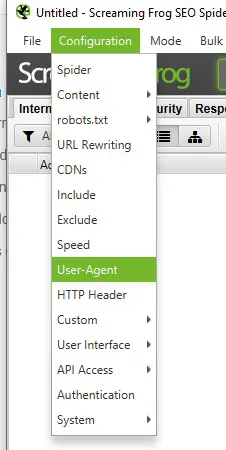

Escolhendo o User-Agent no Screaming Frog

User agent se refere basicamente ao agente de usuário, que participa do processo de renderização e apresentação do conteúdo final para o usuário.

É através dele que faremos o rastreamento e renderização das páginas!

O Google, por exemplo, para encontrar as páginas, indexá-las a ranqueá-las, usar seu próprio User-Agent: Googlebot.

No Screaming Frog, o padrão é usar o robô da ferramenta “Screaming Frog SEO Spider”, que simula bem o Googlebot e costuma ser suficiente.

Mas, caso você queira, pode mudar para outros User Agents, inclusive para o próprio Googlebot:

Para isso, acesse “Configuration” >> “User-Agent” >> Escolha qual User-agent que deseja usar para o rastreamento e renderização.

Inclua pastas específicas e exclua páginas/categorias que não quer rastrear

Essa configuração permite que você bloqueie ou permita o rastreamento de páginas/caminhos de URL específicos.

Por exemplo, você pode bloquear o rastreamento e renderização de páginas que contém /blog/, para fazer uma análise separada entre blog e site.

Para fazer isso, você pode acessar “Configuration” >> “Exclude” >> Adicionar a regra com regex: .*/blog/.* >> Testar na aba “Test” para ver se a regra funciona com algum exemplo!

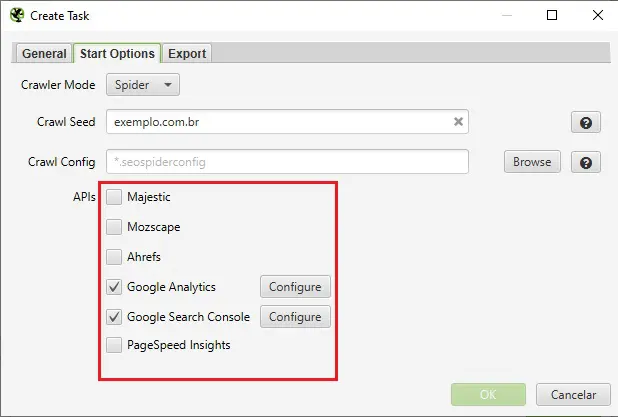

Integração GA, GSC e PageSpeed

Outra parte muito importante, antes de começar a usar o Screaming Frog, é a integração com todas suas outras ferramentas de SEO.

A integração é gratuita, basta conectar-se às suas contas, para conseguir cruzar dados do Screaming Frog com sessões do GA, cliques do GSC e palavras-chave por página, por exemplo!

Você pode integrar às seguintes ferramentas:

- PageSpeed Insights

- Google Analytics

- Google Search Console

- Majestic

- Moz

- Ahrefs

Para usar a API dessas ferramentas, acesse “Configuration” >> “API Access”.

Essa integração é fundamental, pois permite uma fonte muito rica para identificação de oportunidades.

Você pode, por exemplo, encontrar páginas com uma quantidade de sessões razoáveis em SEO, mas com poucos links internos, o que pode ser uma oportunidade para reforçar a página e potencializar ainda mais seus resultados!

As possibilidades são infinitas, use esses dados com criatividade e uma visão estratégica, para aumentar seu impacto com correções técnicas de SEO.

6 Funcionalidade “escondidas” do Screaming Frog

Agora que você sabe o básico sobre as configurações do Screaming Frog, veja algumas funcionalidades e análises muito úteis que grande parte dos usuários da ferramenta não conhecem:

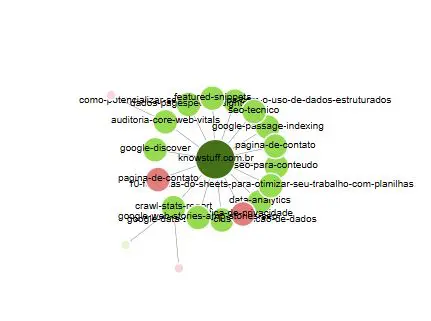

1. Visualizações do Screaming Frog: entendendo a estrutura de seu site

Essa janela fica na parte superior da tela da ferramenta e é fundamental para visualizar a estrutura de seu site.

Se você tem dificuldades ou precisa apresentar a estrutura de um site de forma mais visual, essa funcionalidade vai te ajudar muito!

OBS: essa janela só funciona depois de finalizar o rastreamento e renderização e ativar a opção “Crawl Analysis”!

Para acessar a janela, no menu principal, clique em “Visualizations”. Você verá algumas algumas opções:

- Crawl Tree Graph: aqui você pode visualizar uma estrutura desenhada do site, com base no rastreamento de cada URL. Se você colocar o mouse em cima de qualquer página, poderá visualizar mais informações como title, response code, links internos para a página e mais!

- Directory Tree Graph: essa opção exibe não só os posts, mas também as categorias e subcategorias do site, com suas respectivas páginas. É interessante ter uma visão da arquitetura do site e como cada tema está distribuído.

- Force-Directed Crawl Diagram: essa é uma das minhas favoritas! A ferramenta gera uma visualização totalmente interativa mostrando como as páginas se relacionam. Com essa visualização você pode identificar com facilidade quais categorias estão com poucos links internos e quais páginas estão mais distantes da home, que poderiam ser otimizadas.

- Inlink Anchor Text Word Cloud: aqui também você tem uma visualização em nuvem dos textos âncoras utilizados em links internos. Ou seja, você pode visualizar exatamente quais são os mais repetidos e como você está distribuindo a autoridade do site internamente.

Você pode ver mais na própria documentação do Screaming Frog sobre as visualizações!

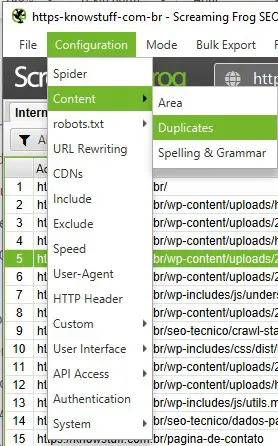

2. Conteúdo duplicado: checando se há similaridade alta entre as páginas do site

Outra funcionalidade ainda não muito explorada pelos usuários é para checar se há conteúdos duplicados nas páginas.

Para usar esse recurso, você deve ativá-lo em “Configuration” >> “Content” >> “Duplicates”.

Você deve acionar a opção “Enable Near Duplicates” e definir o nível de proximidade que pode ser considerado como uma duplicata, o padrão é 90% do conteúdo igual ou similar, mas você pode aumentar ou diminuir esse valor para encontrar todas duplicatas possíveis.

Após selecionada essa opção e feito o rastreamento das URLs, basta acessar a janela “Crawl Analysis” e selecionar “Start” para que esses dados apareçam na ferramenta.

Obs: a opção “Crawl Analysis” é feita após o rastreamento do site, para apresentar informações adicionais às encontradas nas páginas, como duplicatas, erros de gramática, entre outros recursos após o crawl.

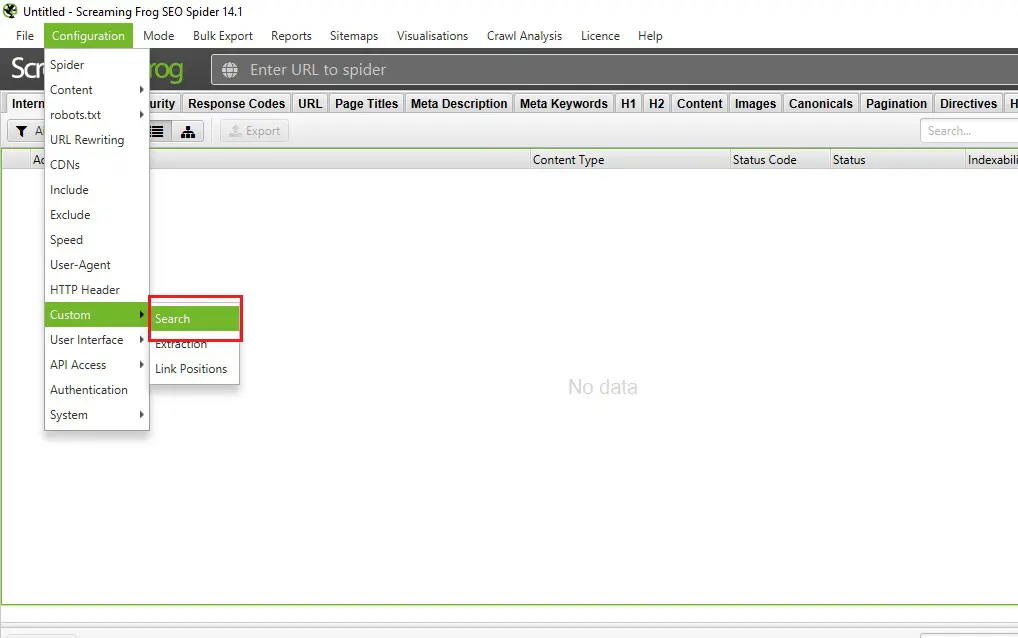

3. Custom Extraction & Search: extração personalizada de elementos das páginas

Como você deve ter percebido, a ferramenta é bem flexível e conta com diversos recursos. Mesmo assim, se você ainda não tiver informações suficientes, pode usar o recurso de extração customizada!

Através desse recurso é possível buscar e armazenar elementos específicos das páginas durante o crawl, como o atributo HTML srcset de imagens ou as próprias tags de cada página.

Saiba mais sobre SEO para Imagens!!

Para usar essa customização basta acessar: “Configuration” >> “Custom” >> “Extraction”.

Para adicionar uma extração customizada, você deve clicar em “Add” e então optar pela forma de extração:

- Regex

- Xpath

- CSS Path (recomendo pois costuma funcionar bem em minhas extrações)

Você pode optar também pelo que deseja extrair quando achar a busca definida pela regra anterior:

- O elemento HTML selecionado por inteiro

- Todo conteúdo HTML dentro do elemento selecionado

- O texto do elemento HTML: por exemplo, o texto da H1 presente na página

- Valor da função: para contar a quantidade de vezes que um mesmo elemento aparece na página, como H1, por exemplo

Outro recurso bem parecido é o Custom Search, que, ao invés de pegar um elemento e seu conteúdo que pode variar, pesquisa por elementos específicos nas páginas que você define!

Você pode, por exemplo, utilizá-lo para pesquisa pelas páginas que não contém o script do GTM, por exemplo.

Você pode também pesquisar pelos conteúdos que estão com a palavra “Fora de estoque” para ver exatamente quais são as páginas com produtos indisponíveis, assim como exemplifica o Screaming Frog em seu guia.

Use a criatividade, pois esse recurso pode ajudar na identificação de vários problemas, como de um script pesado e em quais páginas o mesmo está para otimização de performance.

Enfim, são infinitas as possibilidades!

4. Páginas órfãs

O screaming frog também permite que você encontre páginas órfãs no site, com base no sitemap e Google Analytics.

Página órfã: é aquela página que não contém links internos de outras páginas no site. Em alguns casos elas nem são encontradas devido à ausência de links para elas, porém, muitas delas estão presentes no sitemap ou geram sessões que ficam registradas no analytics, por isso é possível encontrá-las pela ferramenta.

Para usar essa funcionalidade, basta acessar o relatório de sitemaps ou do GA e selecionar a opção “Orphan URLs” para visualizar todas URLs com um total de zero links internos.

Lembre-se de configurar o Analytics e nas configurações do Spider selecionar a opção “Crawl Linked XML Sitemaps” e indique o(s) sitemap(s) do site!

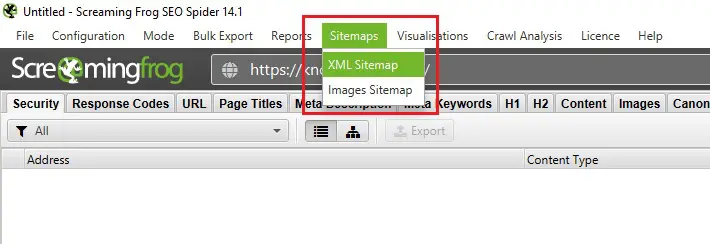

5. Criação de sitemaps

Esse recurso é muito legal para quem não usa uma plataforma com wordpress e tem mais dificuldades para criar um sitemap do site.

Por meio dele você pode exportar o arquivo sitemap das páginas e imagens de forma muito simples:

Basta acessar “Sitemaps” >> “XML Sitemap” ou “Images Sitemap” e configurar seu sitemap!

Você pode editar fatores como:

- Frequência de mudanças das páginas que será indicada no sitemap

- Quais tipos de páginas entram no sitemap (paginação, PDFs, etc…)

- Mais!

Após criar seu sitemap do zero sem muito trabalho, você pode implementá-lo no site e garantir que seja atualizado a cada nova criação/atualização de página sem precisar usar mais o screaming frog toda vez que tiver uma nova URL.

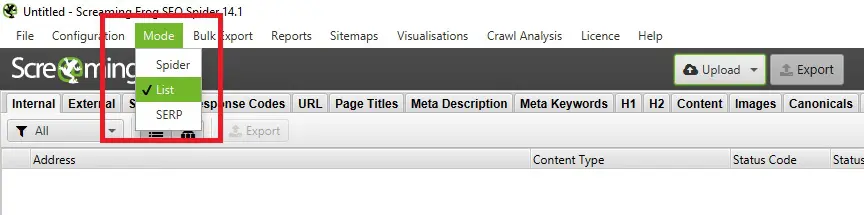

6. Modo Lista

O modo lista permite que você escolha exatamente as URLs das quais deseja coletar os dados de SEO!

Você pode utilizá-lo para identificar fatores de SEO que os primeiros colocados para uma consulta tem, por exemplo, extraindo dados como Title, H1, H2 e até dados estruturados de cada uma das páginas selecionadas.

Essa função é muito boa para analisar concorrentes e até fazer pesquisas de SEO,correlacionando cada elemento com a posição da página.

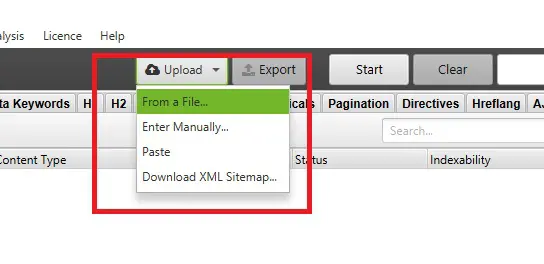

Para utilizar o modo, basta acessar “Mode”>>”List”>>”Upload”.

Então, escolha a opção para importar as URLs (você pode inserir a lista manualmente, importar ela por um arquivo ou usar o próprio sitemap).

Como analisar os dados apresentados pelo Screaming Frog?

Agora que você conhece algumas das principais e mais úteis funcionalidades da ferramenta, vamos partir para uma parte mais analítica:

Afinal, como analisar os dados apresentados no Screaming Frog pensando na relação esforço/impacto?

Precisamos entender quais são os erros mais críticos para SEO.

Entre eles, com certeza um dos mais prioritários é quando a página está impedida de ser indexada por algum motivo como meta robots noindex ou canonical tag errada.

Portanto, ao iniciar sua análise, sempre veja nas diretivas se há alguma página com esse tipo de problema e que são importantes para o posicionamento (podem haver páginas com meta robots noindex justificada, sem problema algum).

Nota: lembre-se de verificar,além das diretivas da meta tag, se a resposta HTTP X-Robots também não está comprometida. Essa resposta nada mais é do que outra forma de fornecer alguma diretiva para o Google, como noindex.

A canonical também é fundamental checar. Veja se uma página não está “canonicalised”, oq eu significa que a canonical está apontando para uma página alternativa à URL (mais uma vez, isso pode ocorrer em alguns casos e não ser um problema).

Outra parte fundamental também é checar erros 404 em “Response Codes” e cadeias de redirects ou muitos redirects sem necessidade.

Nota: cadeia de redirects é quando um redirect não leva à página que retorna 200 e sim outro redirect, gerando uma reação em cadeia que pode interferir em como o Google rastreia suas páginas.

Para corrigir esses erros, você deve checar quais são os “inlinks” (links internos) em seu site que levam para essas páginas e então alterá-los.

No screaming frog você consegue ver não só exatamente cada link interno que uma página recebe, mas também a posição desses links (se estão no conteúdo, footer, header…).

Você pode personalizar também para classificar a posição dos links como quiser no menu em “Configurations” >> “Custom” >> “Link Positions”.

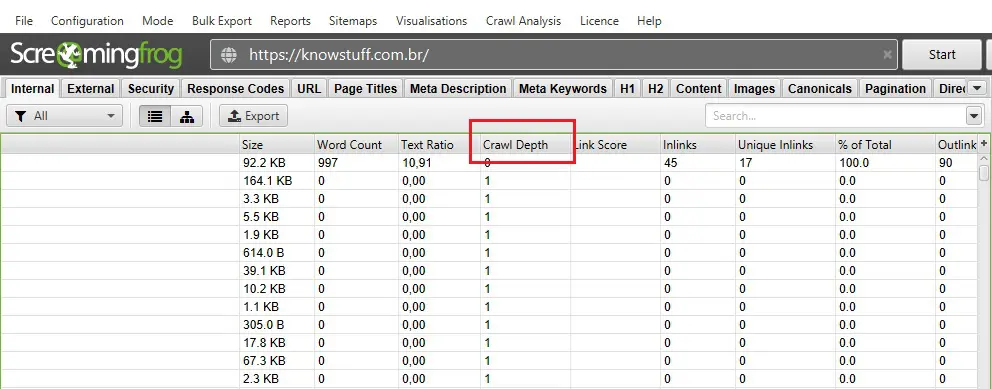

Outra análise que você não pode deixar de fazer no screaming frog, é para entender a estrutura do site e como a autoridade está sendo distribuída pelas páginas.

Para isso, além dos recursos de visualização que mostrei no tópico anterior em “Force-Directed Crawl Diagram”, é fundamental também entender em qual nível de profundidade estão suas páginas em média no site.

Isto é, o quão distantes elas costumam estar da home. Quanto mais distantes, menos efetiva está sendo a distribuição de autoridade!

Para visualizar isso, além de conseguir ver cada página exclusivamente – na coluna “Crawl Depth” – você também pode acessar a janela na parte superior direita da tela chamada de “Site Structure”.

Você verá, abaixo da primeira parte da tela, um gráfico exatamente com as informações de crawl depth do site como um todo.

Aqui é legal ver como suas páginas estão sendo linkadas e se há páginas muito distantes da home – acima do nível 4 já pode ser considerado um pouco distante.

- Validação das páginas AMP encontradas

- Validação e identificação de dados estruturados em cada página

- Detalhes sobre Imagens no site (se estão muito pesadas, sem alt text…)

- Detalhes sobre o conteúdo (conteúdos muito curtos, duplicatas…)

- Análise de title e H1 duplicadas

- Problemas com protocolos de segurança em “Security”, como URLs em HTTP

- Problemas com sitemap (redirects no sitemap, URLs marcadas com noindex, páginas órfãs…)

- Mais!

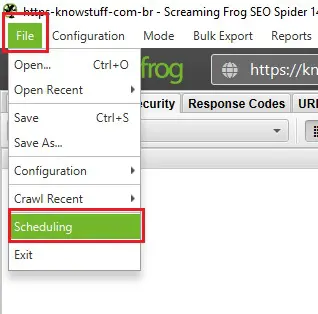

Como agendar crawls e passar tudo para uma planilha de forma automatizada no Screaming Frog?

Chegamos à parte mais fácil do guia: agendar seus crawls para não ter que fazer o mesmo trabalho manual repetidas vezes.

Para agendar, você deve acessar a aba “File” >> “Scheduling” >> “Add”:

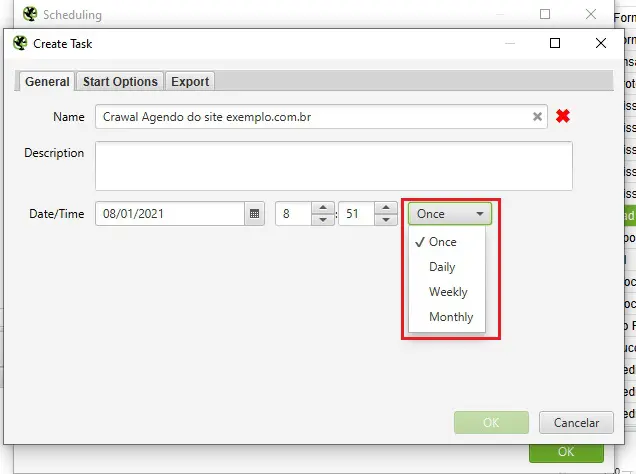

Na primeira tela, você deve configurar questões como a hora, dia e frequência do crawl (apenas uma vez, diariamente, semanalmente ou mensalmente…).

Você também pode nomear e descrever do que se trata o rastreamento:

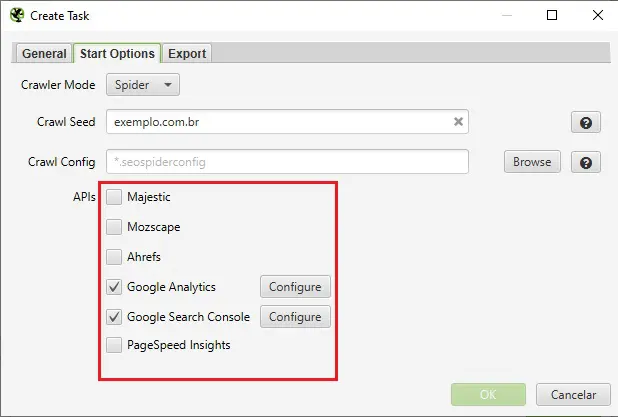

Após isso, acesse a segunda tela e configure as APIs (recomendo usar GA, GSC e PSI, pelo menos). Configure também a URL de início do rastreamento e o modo de rastrear (lista ou spider).

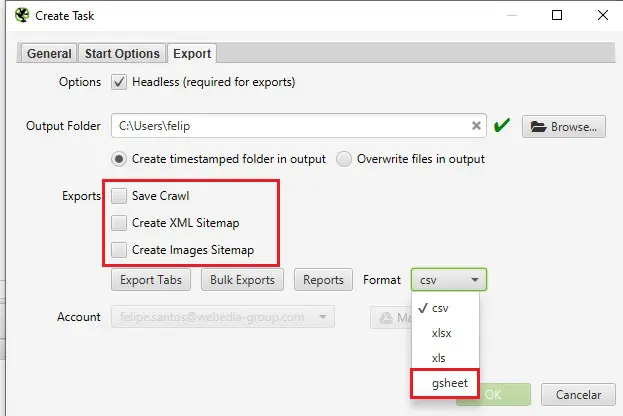

Na última janela, “Export”, é onde você pode fazer a configuração para conectar a sua conta no Google Sheets para exportar para uma planilha!

Além disso, você pode fazer algumas configurações para criar um sitemap, caso precise.

Por fim, ainda na aba Export, você deve configurar exatamente quais dados deseja exportar da ferramenta em “Export Tabs” e “Bulk Export”, selecionando a mão cada dado que precisa ou optando por exportar todos.

Pronto! Agora você tem o que precisa para fazer análises completas na ferramenta e, aos poucos, se tornar um expert, pois, como muitos sabem, é a prática que leva à perfeição!

Aproveite que chegou até aqui para ler nosso conteúdo sobre o relatório do Google Search Console: Crawl Status Report, com ler seus dados e ter insights fundamentais!