No dia 24/11/2020, dois dias atrás, o Google anunciou o lançamento da nova versão de seu relatório do Search Console: Crawl Stats report ou Estatísticas de rastreamento.

Para quem não sabe, o relatório já existia há muito tempo, e você podia acessá-lo pela seção de ferramentas e relatórios legados do Search Console:

Agora, ele incorporou o relatório na interface recente do search console e adicionou diversas features, que nos ajudam a entender o comportamento de rastreamento nos sites com maior profundidade.

Minha ideia neste artigo é passar por todas as partes novas e antigas do relatório, para explicar de forma prática como ler e ter insights práticos com esses dados!

O que é e para que serve o Crawl Stats report?

Começando por aquela pergunta básica de conteúdo para SEO “o que é e para que serve”: basicamente, o relatório exibe dados referentes ao histórico de rastreamento do Google em seu site.

Por exemplo, através dele podemos ver exatamente quantas solicitações para as páginas do site foram feitas pelo Google, e qual foi a resposta recebida.

Ou seja, ele serve para que você veja possíveis erros que o Google encontre durante o rastreamento de seu site, o que pode afetar a indexação de seus conteúdos (por mais lindos, completos e otimizados para UX que sejam).

Vale ressaltar que, diferente de outras fontes do Search Console, esse relatório apresenta dados referentes a todos as solicitações feitas pelo Google, isso significa que redirects (3xx) serão contabilizados como solicitações únicas e podem ser tratados de forma separada.

OBS: O Google passa por todo um processo para indexar seus conteúdos, antes mesmo de avaliar a qualidade dos mesmo.

Isso significa que se seu site não estiver otimizado para esse processo, não importa o quão incrível, completo e otimizado seja seu conteúdo, ele não vai posicionar!

Caso não entenda como funciona o processo para indexar um conteúdo (crawling, rendering e indexing), aqui vai um print que ilustra bem:

Sem mais enrolação, vamos para a prática, passando pelos dados da ferramenta e insights práticos!

Informações do relatório

No relatório você encontrará as seguintes informações:

- Total de solicitações de rastreamento (Total crawl requests)

- Tamanho total do download em bytes (Total download size)

- Tempo médio de resposta em ms (Average response time)

- Status do host

- Respostas de rastreamento (Crawl responses)

- Tipo de arquivo (File Type)

- Finalidade do rastreamento (Crawl purpose)

- Tipo de Googlebot (Googlebot type)

Você pode interagir com as tabelas no relatório para ver em mais detalhes solicitações específicas e entender qual foi o erro encontrado – caso tenha algum – e em qual URL.

Vou entrar em mais detalhes sobre cada uma dessas partes:

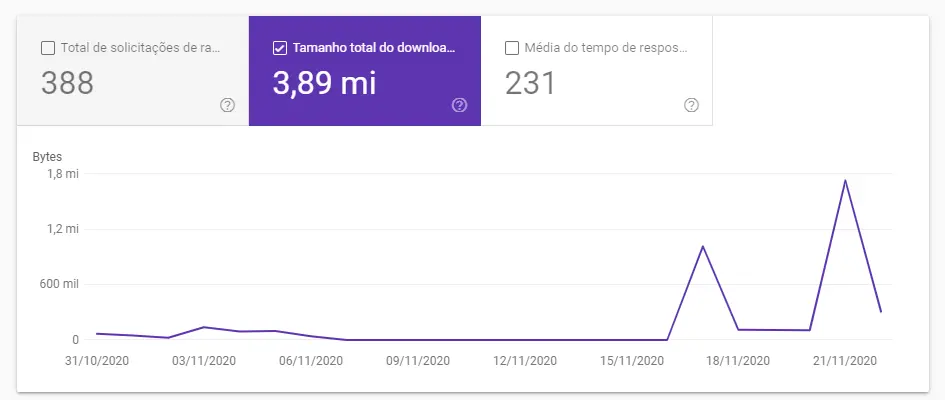

Total de solicitações de rastreamento (Total crawl requests)

Aqui você tem o número total de solicitações feitas nas URLs de seu site, incluindo as solicitações de recursos na página como um arquivo .js.

Como é exibido o histórico de rastreamento do site, você pode entender melhor se houve alguma anomalia no rastreamento durante determinada período.

Então, por exemplo, se notou uma queda em sessões no site durante a semana do dia 22 de novembro, pode ver essa data pelo relatório e entender se houve diminuição do rastreamento (lembrando que há diversos outros fatores para checar também, como meta tag robots, linkagem interna e os próprios conteúdos).

Esse relatório pode te ajudar bastante quando há quedas difíceis de explicar no site, pois você vê exatamente se o Google teve algum problema ao rastrear suas URLs e pode consertar o problema pela raiz.

Tamanho total do download em bytes (Total download size)

Aqui você tem acesso a informações sobre o quão pesadas estão suas páginas e se houve alguma alteração significativa, que pode afetar no rastreamento das páginas e, consequentemente, em sua indexação.

Se notar um pico muito alto nessa parte, é importante falar com o time de desenvolvimento para entender se houve alguma mudança ou atualização no site que possa ter causado esse aumento.

Importante: ter um volume alto aqui não é necessariamente ruim, pois depende do tamanho de seu site e diversos outros fatores. Em alguns casos, o pico pode ser ocasionado pela substituição de um recurso específico presente em várias páginas, que não estava salvo no cache do Google, por exemplo.

Média do tempo de resposta em ms (Average response time)

A média do tempo de resposta total de todos os recursos em seu site é importante para acompanhar se todos arquivos como scripts e css estão otimizados e se houve alguma mudança quanto a isso.

Aqui um pico muito alto não é muito bom, pois a performance do site é afetada, e isso pode impactar nos rankings também!

Dica: para uma análise mais aprofundada sobre os recursos pesados e lentos na página, você pode usar o PageSpeed Insights.

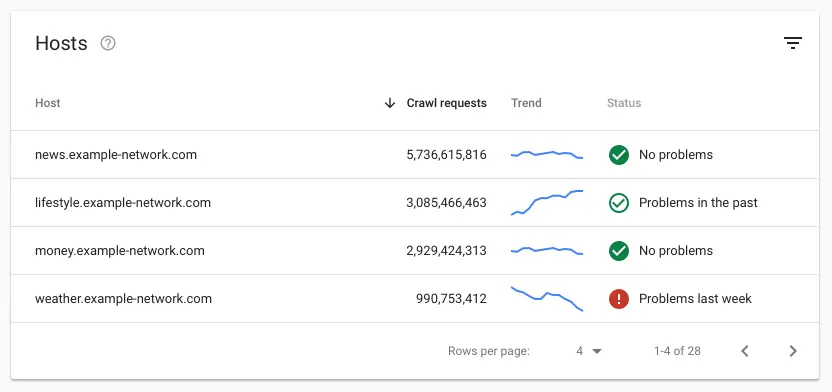

Informações dos diferentes Hosts

No relatório de hosts, você tem uma visão do status de todos os hosts do domínio no search console.

Os problemas com Host são classificados em três categorias:

- Busca de robots.txt: o Google verifica se seu site tem um arquivo robots.txt no formato válido e se ele retorna uma resposta HTTP válida. Caso haja algum problema de conexão ou formato de arquivo, será considerado como erro no relatório.

- Resolução DNS: quando o DNS não reconhece seu host ou não responde durante o rastreamento.

- Conectividade do servidor: são erros com o servidor do site, quando ele não tem uma resposta ou tem uma, mas incompleta.

Como resolver esses erros?

Todos eles precisam de uma visão mais técnica, então minha recomendação é entrar em contato com os desenvolvedores do site para entender o que pode ter causado os erros como corrigi-los o quanto antes, pois são críticos para os rastreamento.

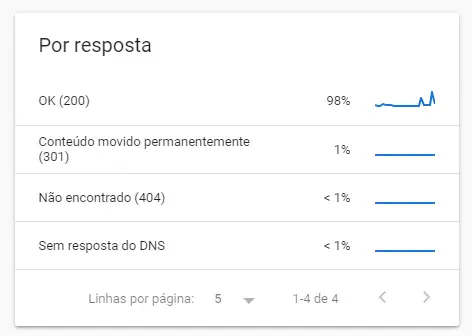

Respostas do rastreamento

Aqui o relatório exibe as respostas HTTP recebidas pelo Google ao rastrear seu site.

Em geral respostas como 404, 301, 302 são normais e não há motivos para preocupação, aqui o Google lista todas as respostas boas, ruins e que precisam de atenção.

Se tiverem muitos redirects e erros 404 aparecendo, pode ser que haja algum problema com esse tipo de URL no sitemap, o que já não é recomendado e deve ser auditado (pelo próprio Search Console você pode ver a reposta HTTP de URLs no sitemap).

Porém, em geral, esses 404s e 3XXs são resultados de links quebrados, que não causam problemas para o site, a não ser que seja em grande escala.

Tipos de arquivos rastreados

Aqui você pode entender melhor a composição de seu site e distribuição entre scripts, HTML e CSS, por exemplo.

Vale a pena investigar bem essa tabela, para entender exatamente quais tipos de arquivos geram problemas e são mais pesados, por exemplo.

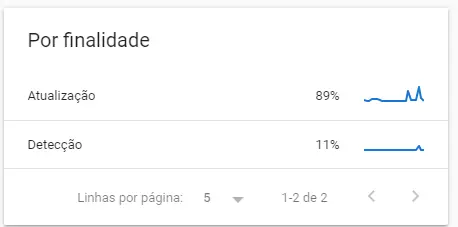

Finalidade do rastreamento

Essa parte do relatório é muito interessante, por mais simples que seja. Nela você pode ver a proporção de URLs rastreadas novamente versus as novas descobertas.

Nota: é comum que seu site tenha uma proporção de “Atualização” muito maior que detecção, pois o Google passa pelo seu site constantemente, incluindo as URLs que já conhece.

Veja um exemplo prático de como usar essa parte do relatório:

Imagine que você lançou uma seção nova na arquitetura do site, com diversas páginas ainda desconhecidas pelos usuários e pelo Google.

Nesse caso, você pode acompanhar se houve algum aumento em “Detecção”. Se após um longo período (uma semana) não acontecer nada, pode ser que tenha algum problema com a implementação dessa seção.

Além disso, você pode ver detalhes sobre o número de solicitações, tamanho de download e tempo médio de resposta apenas das URLs de detecção, por exemplo.

Com isso, é possível ter vários insights para a nova seção no site e determinar se ela está com um bom desempenho no rastreamento.

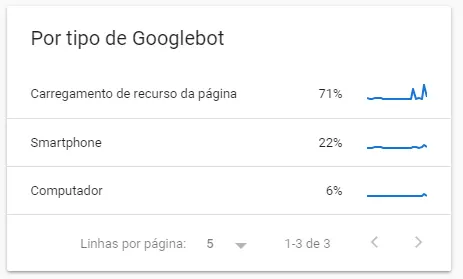

Tipo do Googlebot

Por fim, chegamos ao tipo de Googlebot. O Google conta com diversos user agents para rastrear os sites na web, cada um com finalidades diferentes e programados para encontrar elementos específicos das páginas.

Nessa parte do relatório, você pode ter uma boa noção de quais robôs do Google estão de olho em seu site.

E o que isso significa?

Por exemplo, o Google tem um bot específico de imagem. Um aumento específico do rastreamento de imagens no site pode indicar maior relevância para os resultados do Google Imagens, ou simplesmente que o site aumentou a quantidade de imagens, é preciso analisar com base no contexto.

O que fazer se meu rastreamento estiver muito baixo?

Essa dúvida é muito frequente e a verdade é que, em muitos casos, não temos como saber 100% o que causou o problema, mas há algumas boas práticas que gosto de seguir para encontrar o que pode ter acontecido:

- Verificar o arquivo robots.txt e se nada foi alterado;

- Checar se houve algum problema com a autoridade do site (usar ferramentas como Moz, Ahrefs, SEMrush e Majestic) que pode afetar a relevância do mesmo e, consequentemente, resultar em menos rastreamentos;

- Verificar o tempo de resposta do servidor e se ele costuma apresentar muitos erros (quando o Google percebe que está sobrecarregando o servidor site, ele pode diminuir o ritmo de rastreamento);

- Verificar a velocidade de carregamento do site pelo Lighthouse, PageSpeed Insights ou outra ferramenta com a mesma finalidade;

- Otimizar – sempre – o conteúdo do site, trazendo informações que coloquem em destaque a autoridade do site no assunto abordado e que tenham relevância. Um bom conteúdo tem mais chances de ser rastreado com maior frequência pelo Google.

Por este artigo é só tudo isso!

Espero ter ajudado com esse “pequeno” update sobre o novo relatório de rastreamento do Google 🙂