Robots.txt é um dos arquivos mais simples que um site pode ter!

Longe de ser um dos fatores mais avançados de SEO, esse arquivo pode ser facilmente criado, editado e entendido.

Mas é preciso tomar cuidado! Um simples comando errado de disallow no robots txt pode comprometer o seu site inteiro!

Portanto, apesar de ser um arquivo simples, é preciso saber como você deve utilizá-lo para o bem de SEO e como validá-lo, para garantir que esteja tudo em ordem.

Este post se destina a isso:

Fiz um guia completo para você entender o que é e como usar robots.txt, comandos, quando utilizá-los, além de algumas dicas de SEO para lidar com esse o arquivo.

Dá uma olhada!

O que é robots.txt?

Robots.txt é um arquivo de texto – formato .txt, como no bloco de notas padrão do windows – que tem como função instruir os web crawlers de mecanismos de pesquisa – como o Google – sobre como devem rastrear suas páginas.

O arquivo pode ser utilizado, por exemplo, para bloquear o Google de rastrear as páginas de login, afinal, elas não têm valor para SEO e o robô do Google não deveria “perder” seu tempo em páginas que não façam sentido.

Esse foi apenas um exemplo, há diversos outros casos em que o bloqueio do Google de rastrear algumas URLs no seu site faz sentido e vou entrar em mais detalhes sobre os principais deles mais à frente!

Antes é importante falar sobre um GRANDE mito entre SEOs relacionado ao arquivo, de que ele bloqueia o Google de indexar as páginas em seus resultados de pesquisa.

Essa informação é falsa, por incrível que pareça!

O arquivo instrui o Google sobre quais páginas ele pode rastrear/acessar ou não!

Ou seja, ele não pode acessar o conteúdo dessas páginas e isso geralmente resulta na não indexação dos conteúdos bloqueados.

Porém, caso existam links internos do site para esses conteúdos ou outras formas de acessá-los, eles podem sim e são indexados em alguns casos, mesmo o Google sendo bloqueado de acessar os conteúdos pelo robots txt (para garantir que esses conteúdos não sejam indexados é preciso adicionar a diretiva noindex ou canonical tag, dependendo do caso).

Como funciona o arquivo robots.txt?

# Group 1

User-agent: Googlebot

Disallow: /nogooglebot/

# Group 2

User-agent: *

Allow: /

Sitemap: http://www.example.com/sitemap.xml

Vamos destrinchar esse arquivo agora para você entender cada parte:

User-agent

É um software que tem como objetivo – resumindo – conectar o usuário que o está utilizando a um conteúdo na web.

O Google Chrome, por exemplo, tem um User-Agent diferente do Internet Explorer, que por sua vez é diferente do Safari, por assim vai…

Os robôs dos algoritmos do Google também tem seus user-agents para acessar os conteúdos na web e classificá-los, sendo os mais famosos:

- Googlebot

- Googlebot Image

- AdsBot

- Googlebot News

- Outros

Cada um deles – também chamados de web crawlers- tem a função de rastrear diferentes conteúdos na web.

O Googlebot Image, por exemplo, como o próprio nome indica, é específico para o rastreamento e “diagnóstico” de imagens nos conteúdos (saiba como fazer SEO para imagens).

Allow/Disallow

Nada mais é do que a diretiva que você dá para o user-agent definido na linha anterior.

Por exemplo, se eu quiser que o Googlebot não acesse minhas páginas de login, posso adicionar a diretiva disallow, como segue abaixo:

User-agent: Googlebot

Disallow: /wp-admin/

No caso, desautorizei o Googlebot de acessar as páginas que contenham “/wp-admin” na URL, para evitar que páginas de login em meu site sejam indexadas (lembrando que ajuda sim o Google a não indexar essas páginas, mas não é garantia, caso tenha links internos no site para elas, por exemplo).

Sitemap

Outro famoso arquivo de SEO, o sitemap.xml é um arquivo que contém um mapa de seu site, com todas as páginas, posts e categorias indexáveis mais relevantes para aparecer no Google.

Esse arquivo também é totalmente personalizável, mas vale outro post só para falar sobre como criar o seu.

O importante a saber agora é que:

- O arquivo fica na raíz de seu site – caso exista – e, para acessá-lo, basta digitar “/sitemap.xml” após a URL da home

- É importante adicionar essa diretiva para indicar a localização (URL) do sitemap no arquivo robots.txt, pois o robots txt é um dos primeiros arquivos que o Google olha ao descobrir seu site, e o sitemap ajuda ele a entender quais páginas olhar com mais frequência e priorizar na indexação!

* Asterisco

O asterisco ou “estrelinha” ao lado do user-agent na verdade representa TODOS user-agents.

Ou seja, ao colocar o “*” em uma diretiva do arquivo robots.txt, você está dizendo que aquela regra se aplica para todos os robôs (user-agent) que acessarem seu site.

Como usar o robots txt, e quando?

Vamos listar alguns casos de uso para o arquivo:

- Manter seções do site privadas, como páginas de login

Exemplo WordPress:

User-agent: *

Disallow: /wp-admin/

- Prevenir o Google de “perder tempo” em páginas de busca interna do site, para que o Google não fique acessando essas páginas sem qualidade

Exemplo:

User-agent: *

Disallow: /busca/

- Prevenir o sobrecarregamento do servidor, bloqueando seções que não são importantes para aparecer no Google.

- Prevenir que arquivos como restritos de vídeo, PDFs e imagens aparecem no Google

Exemplo (bloquear arquivos no formato pdf):

User-agent: *

Disallow: /*.pdf$

Melhores práticas para o arquivo robots txt

Primeiro vamos falar sobre as melhores práticas para criar seu arquivo sem causar problemas no site, para então chegar no passo a passo para implementar seu arquivo!

Vamos lá?

O arquivo deve ficar no diretório raíz do site!

O que é isso?

Basicamente, ele não pode ficar dentro de nenhuma outra pasta, categoria ou tag, mas sim acessível diretamente a partir do domínio ou subdomínio:

seudominio.com.br/robots.txt

blog.dominio.com.br/robots.txt

O arquivo é sensível a maiúsculas e minúsculas

Portanto, preste atenção ao criar o arquivo para não salvá-lo como: “Robots.txt”, “robots.TXT”…Ele deve conter apenas minúsculas: robots.txt.

A cada diretiva nova criada no arquivo, você deve pular uma linha

Certo

User-agent: *

Disallow: /busca/

Errado

User-agent: * Disallow: /busca/

- Use um arquivo robots.txt diferente para cada subdomínio

Especifique bem suas regras!

Por exemplo, se você usar a seguinte regra:

User-agent: Googlebot

Disallow: /blog

Nesse caso, você bloqueia não só as páginas dentro de blog, mas também quaisquer que contenham “/blog”, como:

/bloger-ensina-como-criar-seu-site-do-zero

Para evitar o bloqueio de páginas sem querer, especifique mais:

User-agent: Googlebot

Disallow: /blog/

Dessa forma, somente páginas dentro de “/blog/” serão bloqueadas (preste bastante atenção nesses detalhes, pois podem causar muito problemas)!

Não repita o mesmo User-agent

Se for bloquear diferentes tipos de páginas para o mesmo User-agent, não faça dessa forma:

User-agent: Googlebot

Disallow: /a/

User-agent: Googlebot

Disallow: /b/

Apesar de não ter problema, pode gerar confusão em você mesmo depois, então o melhor é simplesmente declarar o user-agent uma vez e adicionar novas linhas para cada diretiva:

User-agent: Googlebot

Disallow: /a/

Disallow: /b/

Use o “*” para organizar melhor seu arquivo

O asterisco, além de referenciar todos user-agents, também pode ser utilizado para agregar páginas.

Como assim?

Vamos supor que você deseja bloquear o Google de ver filtros de três páginas de produtos diferentes:

User-agent: * # Todos user-agents

Disallow: /products/bicicleta?

Disallow: /produto/quebra-cabeca?

Disallow: /produto/carros?

Ao invés de listar cada uma delas, você pode simplesmente usar o * da seguinte forma:

User-agent: *

Disallow: /products/*?

Pronto, agora vamos para a criação!

Como criar um arquivo robots.txt?

Confira o passo a passo para criar e configurar robots txt:

Criar e configurar robots.txt pelo WordPress

1) O WordPress geralmente já faz a adição automática do arquivo na raíz de seu domínio e, para acessá-lo, basta digitar:

seudominio.com.br/robots.txt

2) Para editar o seu arquivo, você pode baixar algum plugin como Yoast SEO ou Rank Math SEO, que permitem a edição rápida do mesmo

Criar o robots txt para outro CMS

- Crie o arquivo em um formato txt, como no próprio bloco de notas de seu computador

- Salve esse arquivo no seu computador como robots.txt (minúsculas)

- Após, acesse o FTP de seu site e faça o upload do arquivo diretamente no diretório raíz do site

- Pronto, basta acessar o arquivo para ver se está tudo em ordem!

Erros comuns do search console e como lidar?

“Indexada, mas bloqueada pelo robots.txt”

Esse erro, ou , em inglês: “Indexed, though blocked by robots.txt”, significa que mesmo bloqueada pelo robots txt, a página foi indexada e pode aparecer nos resultados do Google!

É o que eu disse, o arquivo não bloqueia a indexação das URLs, mas sim o acesso do Google e outros bots a elas.

Nesses casos, basta, ao invés de bloquear a URL pelo robots.txt, adicionar a meta tag noindex na página, assim:

meta name="robots" content="nofollow, noindex”/

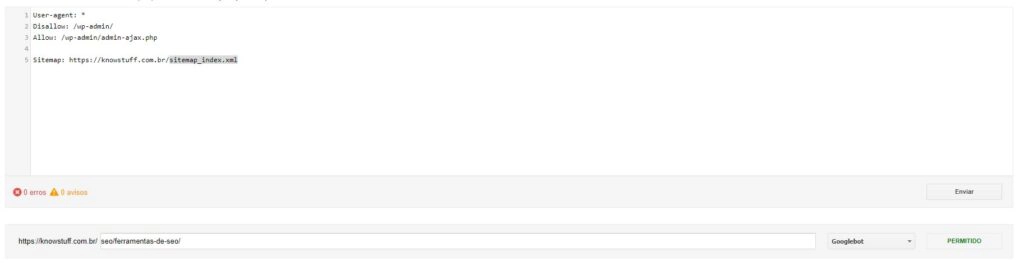

“Bloqueada pelo robots.txt”

Se você não queria que a página fosse bloqueada pelo robots.txt, pode usar a ferramenta de SEO do Google chamada robots.txt tester.

Para utilizá-la, basta colar sua URL e o arquivo robots txt de seu site e o Google vai dizer onde no arquivo está bloqueando a página de ser rastreada:

Gostou do guia?

Aproveite para visitar nosso guia completo sobre o redirect 301 e entender mais sobre como funciona esse redirecionamento e como utilizá-lo para melhorar seu SEO!